Mit dem Erfolg des World Wide Web als global genutztes Hypertext-Informationssystem, entwickelte sich auch die Notwendigkeit für Suchmaschinen, welche die Navigation durch das WWW erleichtern sollten. Mittlerweile liefern Suchmaschinen auf ein Stichwort in Sekundenschnelle unzählige Ergebnisse mit Hyperlinks zu entsprechenden Webseiten. Ohne Suchmaschinen ist der Datendschungel des WWW nicht mehr erfassbar und deshalb wurde bereits in den späten 90er Jahren damit begonnen, Suchmaschinenoptimierung zur Vermarktung seiner eigenen Webpräsenz einzusetzen. Und damals wie heute ist die echte, langfristige und erfolgsversprechende Suchmaschinenoptimierung immer mit harter Arbeit verbunden.

Die Datenmenge des World Wide Web wächst in rasanter Geschwindigkeit und kann aufgrund der dezentralen Architektur des Netzes nur durch spezielle Suchdienste abgebildet bzw. katalogisiert werden. Wenn man also gezielt auf der Suche nach bestimmten Informationen ist und hofft, diese auf den Milliarden von Webseiten zu finden, dann muß man sogenannte Suchmaschinen (z.B. Google, Yahoo, Bing) benutzen. Suchmaschinen besitzen Suchroboter (auch Crawler, Spider oder Bots) die beständig das World Wide Web nach neuen bzw. aktualisierten Webseiten durchkämmen und alle aufgefundenen Dokumente in ihren Datenbanken katalogisieren

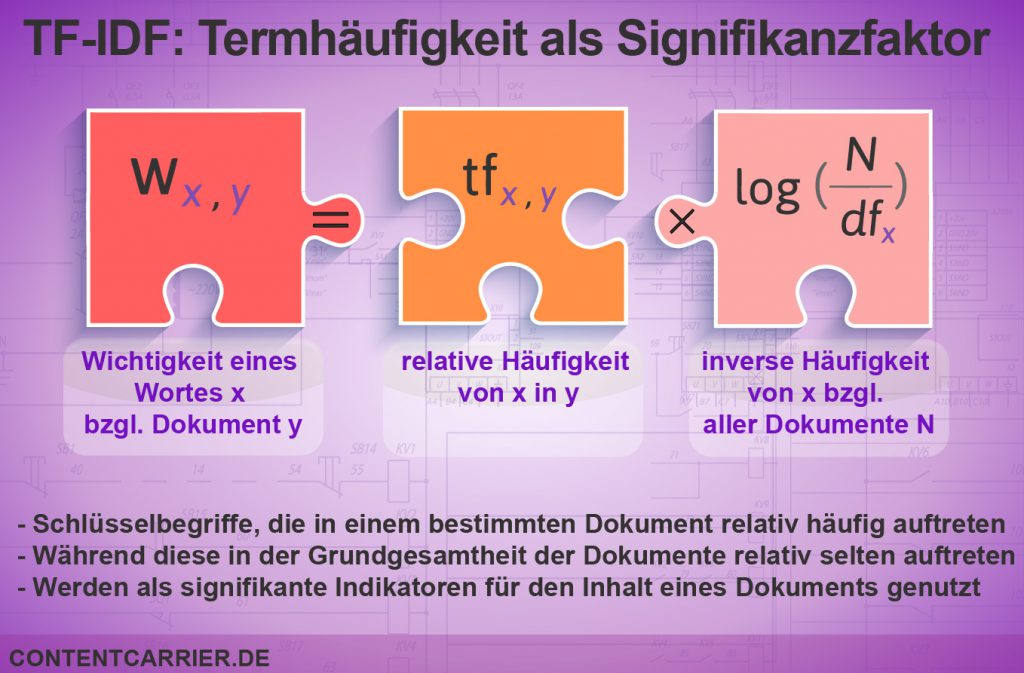

Leider mangelt es den Suchmaschinen an Textverständnis im Sinne von Satz- bzw. Textsemantik. Die Qualitätsbeurteilung bzw. die Anordnung der Dokumente nach Wichtigkeit für die jeweiligen Suchanfragen muss über Hilfskonstrukte realisiert werden. Die Qualität der Dokumente wird dabei vornehmlich nach mathematischen und statistischen Kriterien (zusammengefasst im Ranking-Algorithmus) bewertet und gewichtet, so dass bei einer Suchanfrage, die jeweils relevanten Ergebnisse in einer festgelegten Reihenfolge auf der Trefferseite aufgelistet werden.

Die einzelnen Faktoren und deren Einfluss auf das Ranking bleiben jedoch weitgehend unbekannt bzw. werden geheim gehalten. Einige Kriterien, wie Linkstruktur bzw. der mittlerweile abgeschaffte Google PageRank sind dokumentiert, allerdings ist die heutige Gewichtung und die Kombination mit zahlreichen anderen Faktoren nicht bekannt. Deshalb ranken sich viele Mythen und vage Vermutungen um die möglichen Erfolgsfaktoren im Bereich der Suchmaschinenoptimierung. Insofern sind auch jegliche Maßnahmen und Optimierungen, die das Ranking einer Seite auf den vordersten Plätzen garantieren sollen, immer mit absoluter Vorsicht zu genießen. Denn der Wettbewerb um die Top-Positionen ist hart, gerade wenn man seine Webseite für Google optimieren will, da insbesondere reine Online-Unternehmen auf viele Besucher angewiesen sind, und Umfragen gezeigt haben, dass Suchmaschinennutzer oftmals nur den ersten drei Suchergebnissen größere Beachtung schenken.

Da die Qualität der Suchergebnisse langfristig aber nur über eine gezieltere Erkennung der Inhalte durch Suchmaschinen verbessert werden kann, sollten die Möglichkeiten der inhaltlichen Seitenoptimierung in Zukunft verstärkt genutzt werden. Gerade vor dem Hintergrund des zunehmenden Konkurrenzkampfes um gute Suchmaschinenpositionen kann einzigartiger Content den entscheidenden Wettbewerbsvorteil liefern. Nur wer interessante Inhalte auf seiner Website anbietet, versorgt die Suchmaschinen mit ausreichend Textmaterial und kann auf natürliche bzw. freiwillige Verlinkungen von anderen Seitenbetreibern hoffen und sich so langfristig im World Wide Web behaupten.